作者: DigiKey Editor

关键词:开发板

曾经有一位牧师说过:上帝说要有光? 于是便有了光。

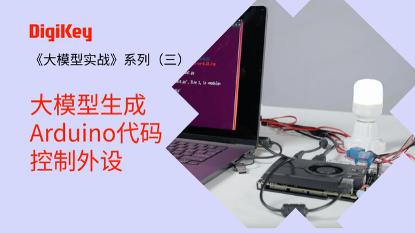

《大模型实战》系列课程的第三节,Lattepanda sigma部署大模型,你也可以做“上帝”了。

相关课程视频,请点以下图片到B站观看:

项目介绍

也许你会说,点个灯小爱同学也会呀。但,小爱同学不会写代码呀。

这个项目的步骤是:

- 第一步,使用麦克风录音,使用Python的库来控制音频输入。

- 第二步,将语音转换为文本。

- 第三步,将得到的文本发送到Ollama API获取回复。

- 第四步,生成Arduino代码并上传,控制灯光。

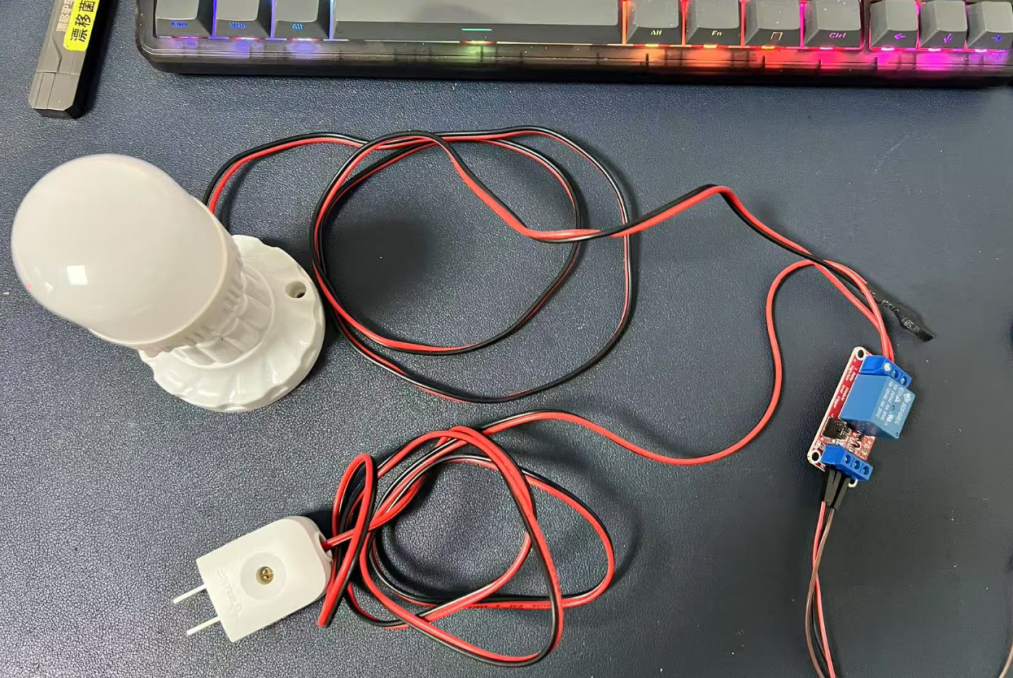

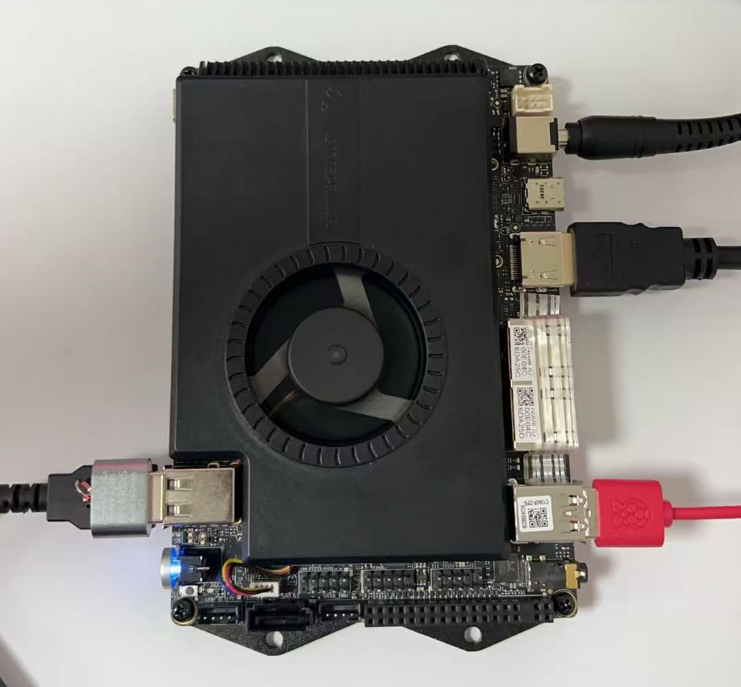

在这个项目中,Lattepanda sigma作为核心主控,搭配一些外围器件,USB麦克风,继电器, 220V电灯和灯座,杜邦线等。此外,为了更好的展示,还需要支持HDMI接入的屏幕,USB鼠标键盘,烧录系统使用的空白8G或更大的U盘。

为什么选择Lattepanda设备来生成代码控制外设?

在现代嵌入式开发和AI模型部署领域,选择合适的硬件平台是项目成功的关键。选择Lattepanda设备的主要原因有一下几点:

1. 强大的硬件性能

配备高性能的处理器和丰富的外设接口,能够轻松应对复杂的计算任务和外设控制需求。其板载的Leonardo单片机为直接控制继电器等外设提供了便利,无需额外的硬件支持。

2. 易于部署的软件环境

支持Ubuntu操作系统,为开发者提供了一个稳定且易于扩展的开发环境。通过简单的系统配置和工具链安装,可以快速搭建大模型运行环境,并实现语音交互和硬件控制的自动化。

3. 语音交互能力

支持USB麦克风的接入,能够通过语音输入实现prompt的录入。结合语音识别(STT)技术和AI模型,可以实现自然语言控制外设的功能,极大地提升了用户体验。

4. AI模型部署的便利性

Lattepanda sigma的高性能计算能力使其能够运行大模型,如Ollama、Qwen等。通过简单的配置和API调用,可以快速生成适合的代码并部署到板载的Leonardo单片机,实现对外设的精确控制。

项目实现过程

第一步,硬件组装

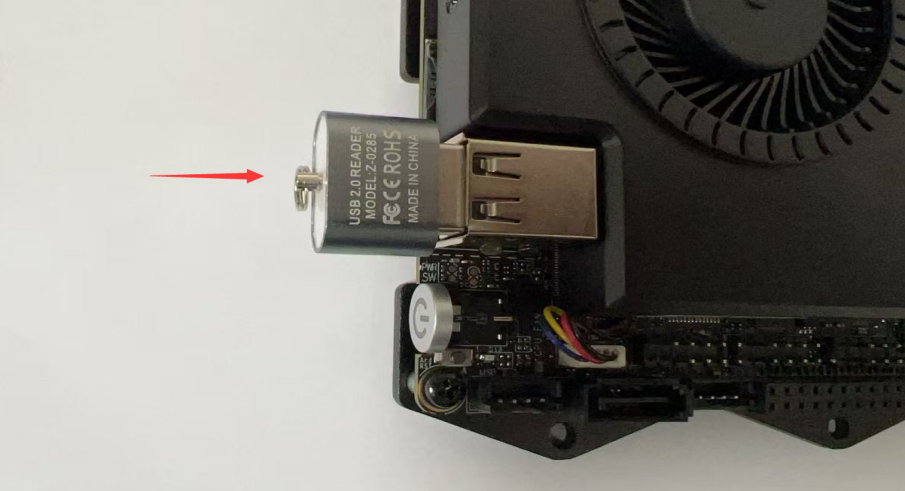

将USB麦克风接入到Lattepanda的USB接口;

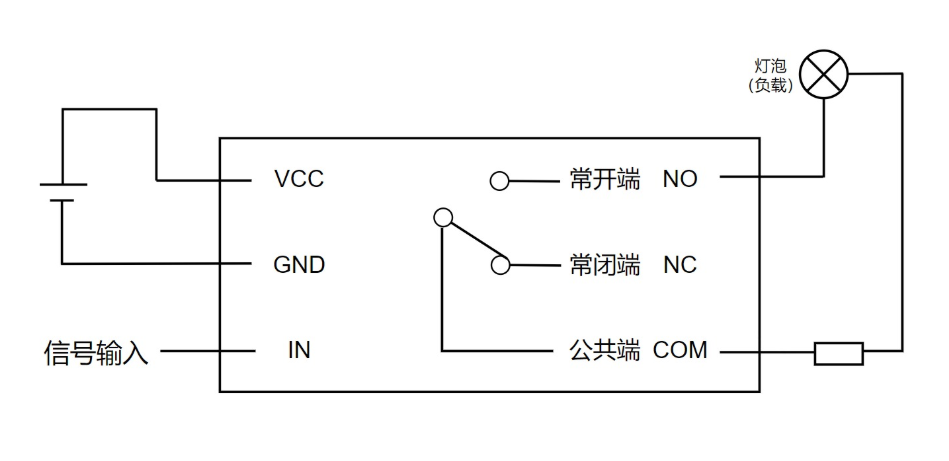

将一路继电器接入到开发板的IO口,其中接入一个GND, 一个5V, 还有一个D11接口接入继电器模块的IN接口。继电器另一端接一个电灯。

第二步,系统安装和初始化配置

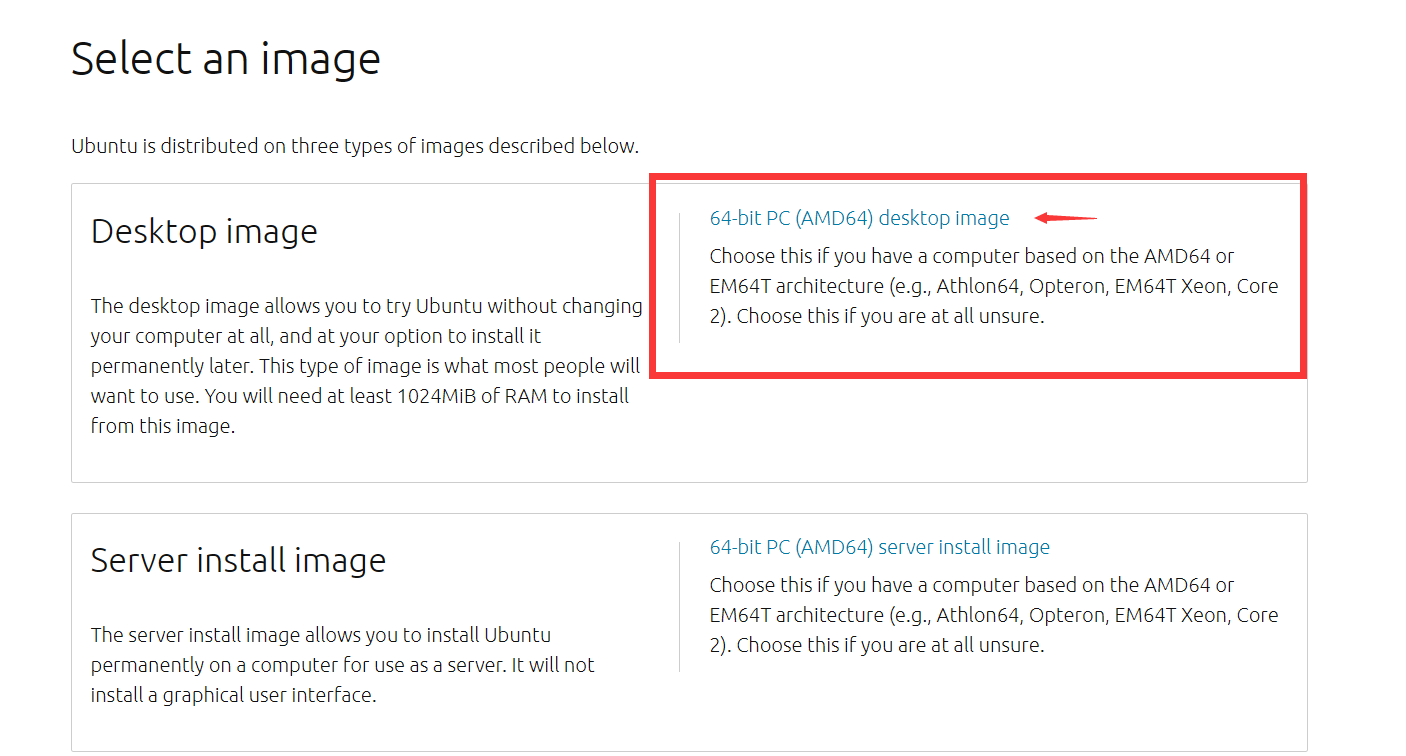

首先,要下载系统镜像,可以根据官方推荐使用的版本进行下载,官方推荐Ubuntu 22.04 LTS版本:

然后,下载rufus烧录软件,选择合适版本下载即可:https://rufus.ie/zh/

烧录软件下载完直接打开,并找到下载好的镜像文件,将文件烧录至网盘中,烧录过程中,磁盘灯会疯狂闪烁:

接下来,将带有系统镜像的网盘插入Lattepanda Sigma开发板上,并接入HDMI线缆、接入DC电源和USB键盘鼠标。

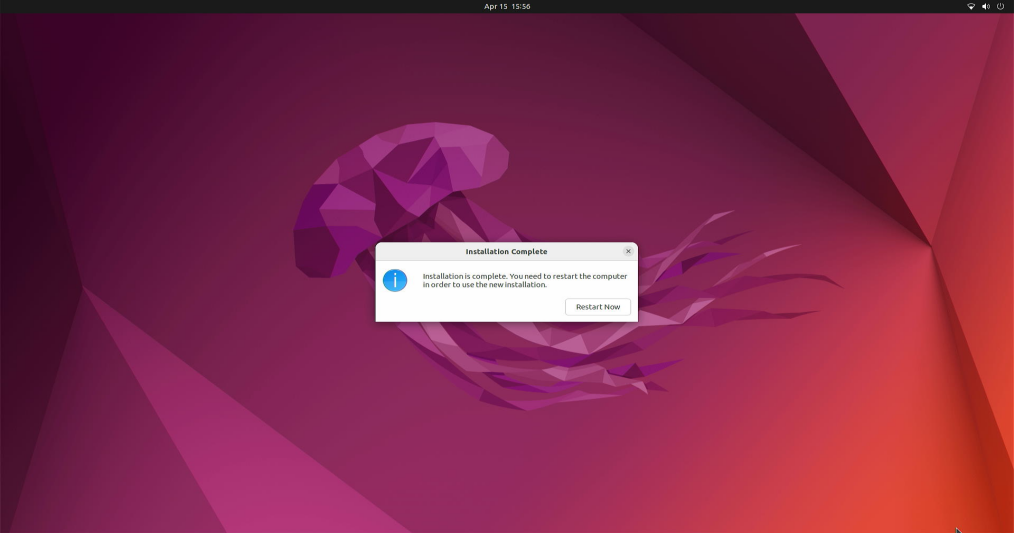

以上硬件连接完成后,就可以点击电源按钮开机。开机第一个操作即多次点击F7按键,进入启动选项设置,继续安装,直到完成:

重启后会出现:

这时候,拔掉USB系统安装盘,然后回车重启设备。开发板即可进入系统:

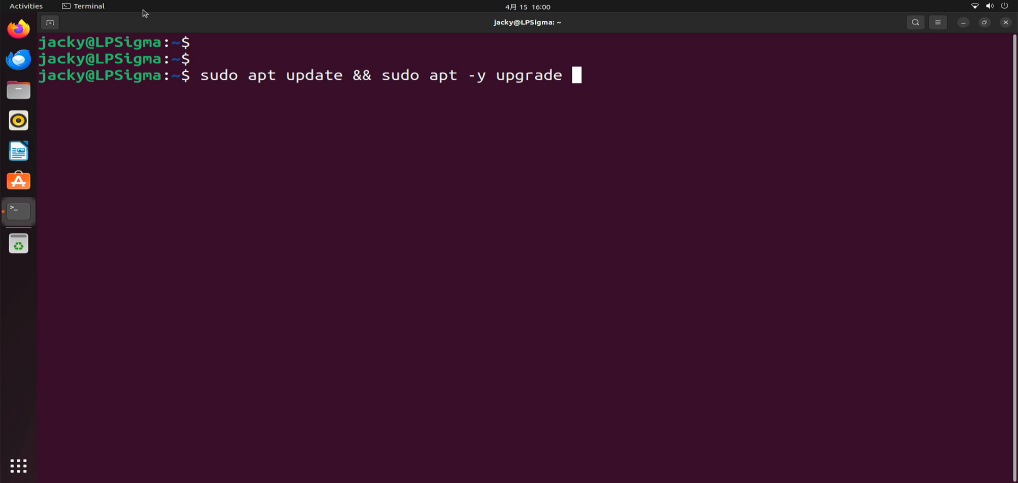

当初始化配置完成后,还需要对系统进行软件仓库索引更新和系统软件包升级.

完成后,根据需要也可以定义软件的本地源,使用国内清华的源或者阿里云的源,也可以使用系统默认的源,可以看到我们系统默认使用的是清华的源,速度会很快完成。

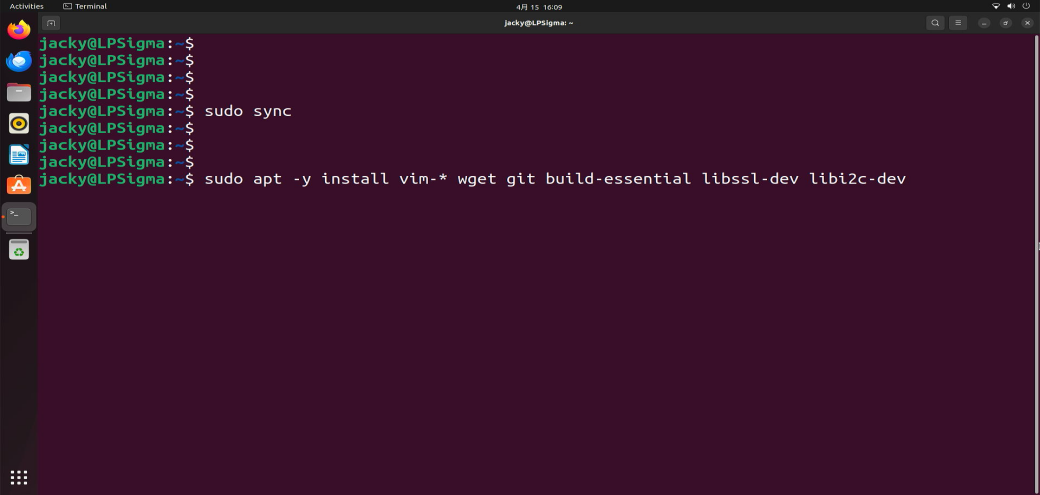

个人喜欢安装vim工具,如果你们不喜欢这步骤可以跳过。

安装了build-essential 后期后面可以做C语言的开发,很方便,当然如果后期你有在LPsigma上开发硬件设备的需求也可以安装cmake工具,例如你如果要开发树莓派pico的开发板,或者开发ESP32的开发板,都可以提前将环境安装好。

一般建议安装完后,重新启动一下设备。

第三步:安装Ollama的框架

Ollama是一个开源的本地化大语言模型(LLM)运行框架,可以简化在个人计算机上部署和运行大型语言模型的过程。

Ollama 支持多种安装方式,包括直接下载安装包、使用包管理器(如 Homebrew)、通过 Docker 等,而且它拥有活跃的开源社区生态,提供了大量的第三方集成和工具,包括web和桌面应用,移动应用,开发库,数据库集成等等,它的高效和安全且易于上手,对于新手非常友好,而Linux下安装也非常简单,打开终端。

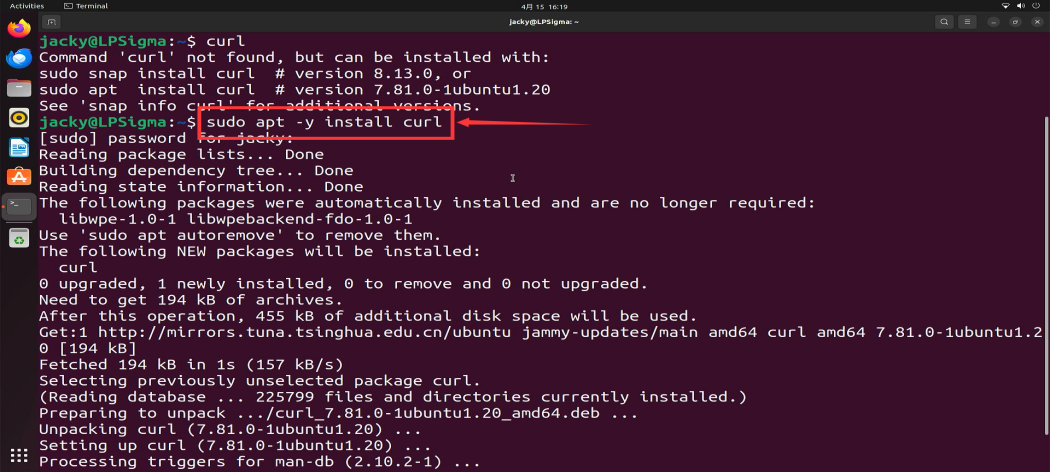

先确认是否安装了curl工具,如果没有就安装一下这个软件包:

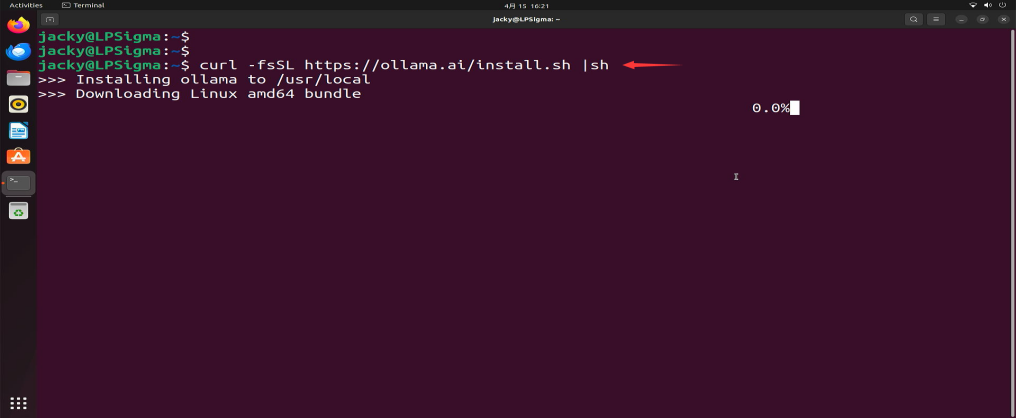

然后在终端中执行:curl -fsSL https://ollama.ai/install.sh | sh

第四步:大模型下载

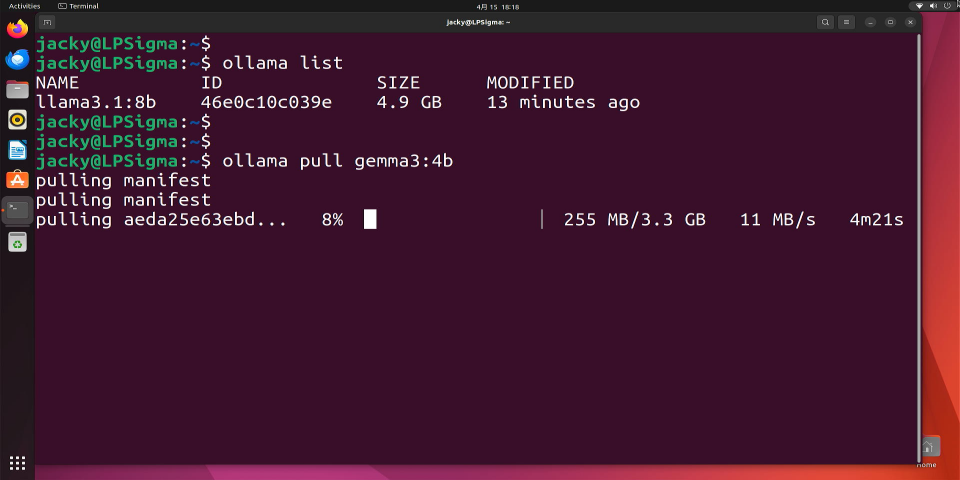

Ollama框架安装完成后,就可以进行模型的下载,目前可用的模型很多,以谷歌的gemma3:4b 这两个模型来作为这次项目的大语言模型。

终端运行,进行模型下载: ollama pull gemma3:4b

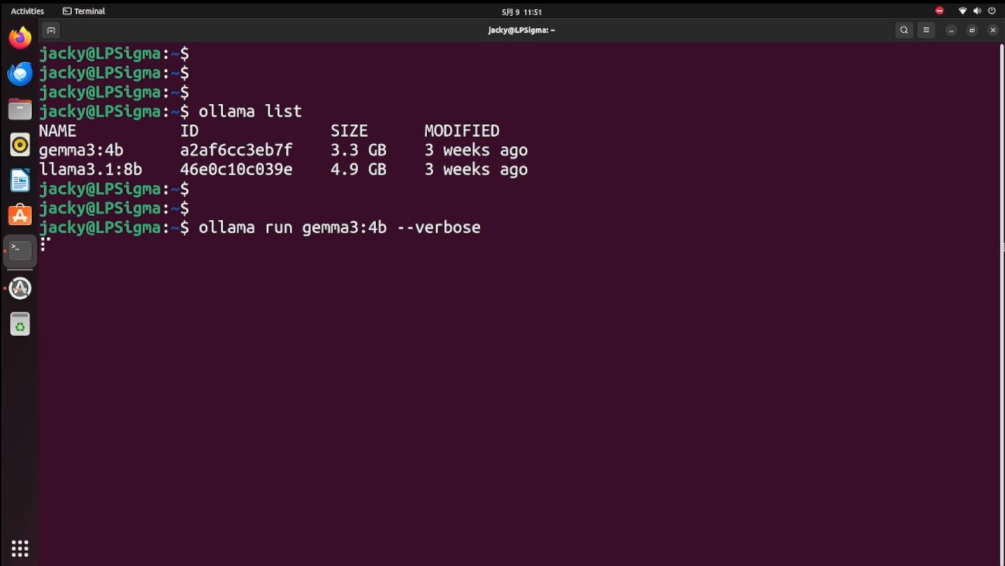

下载完成后,尝试运行:

ollama run gemma3:4b –verbose

然后,就可以进入交互模式和大预言模型对话了,尝试询问一个问题看看响应的时间。

第五步:搭建python虚拟环境以及库文件

一切完成后,可以配置openssh远程登录到服务器,然后搭建python虚拟环境。

conda create -n venv -p python3.11

conda activate venv

在搭建虚拟环境前,先给大家介绍一下操作步骤:

先安装系统依赖:

sudo apt-get update && sudo apt-get upgrade -y

sudo apt-get install -y python3-pip python3-dev build-essential

安装Python库

pip install pyaudio SpeechRecgnition

pip install numpy requests

安装Arduino CLI工具

wget https://downloads.arduino.cc/arduino-cli/arduino-cli_latest_Linux_64bit.tar.gz

tar -xvf arduino-cli* && sudo mv arduino-cli /usr/bin/

arduino-cli core update-index

sudo arduino-cli core install arduino:avr

接下来,需要对语音识别进行测试,编写测试代码,通过USB 麦克风读取声音并使用 pocketsphinx 进行本地语音识别。

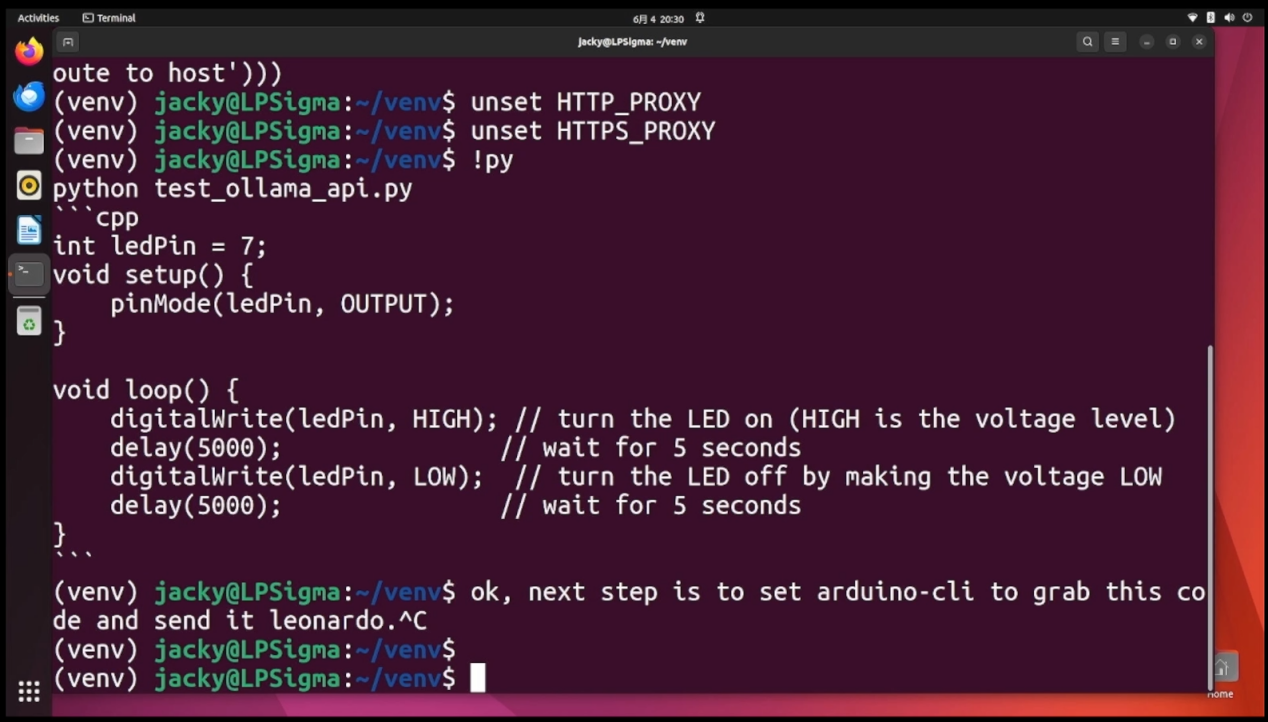

第六步:代码上传至本地Leonardo芯片

需要通过arduino-cli上传代码到本地的Leonardo芯片,这个过程集成在主程序中,主程序会读取后通过arduino-cli命令执行上传,可以打开代码定位到模型输出后操作的部分。

运行主程序: python main.py

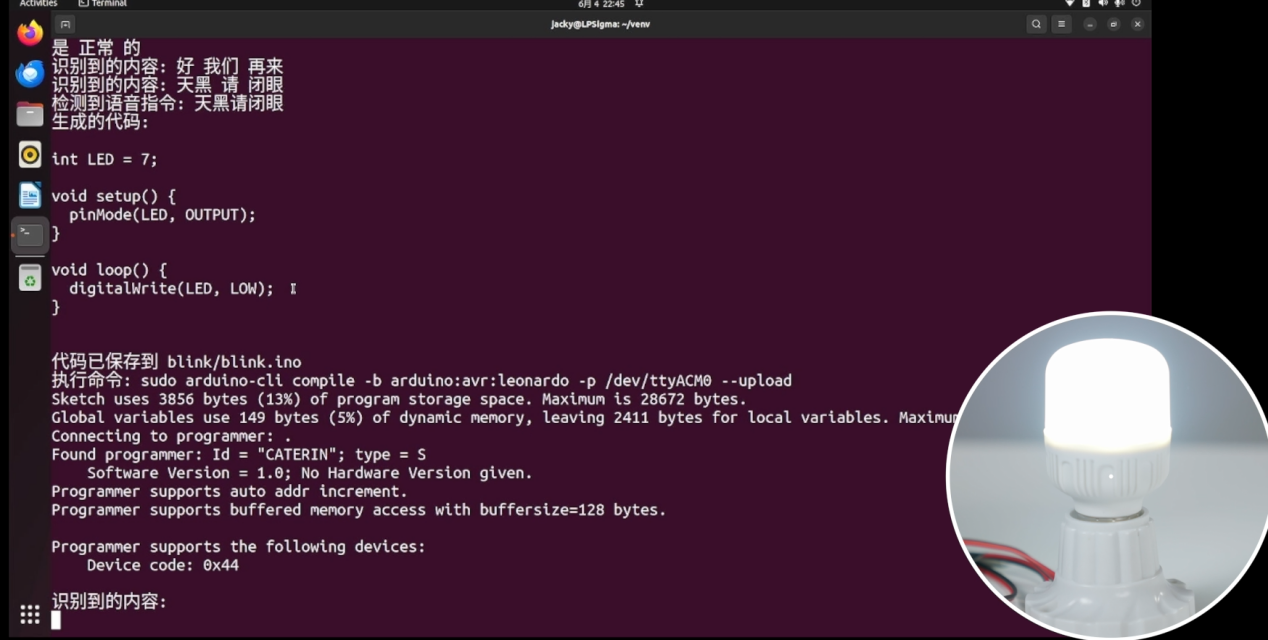

然后对着麦克风说: 上帝说要有光,Lattepanda 上有灯光闪烁,紧接着继电器闭合,外部的灯光会亮起。

对着麦克风说: 天黑请闭眼,这时候,依然会出现烧录时的灯光闪烁,关闭灯光。

这样一来,就可以实现当我们需要不同的电灯需求,只需让模型理解语意就可以实现代码重新编写和上传的功能,大家快去搭建环境试试自己的言出法随吧~

小编的话:

正如视频和文章所介绍的,Lattepanda sigma开发板具备强大的硬件性能,可以轻松应对复杂计算及外设控制,直接控制继电器等外设,能提供稳定且易扩展的开发环境,还具有语音交互能力,其高性能计算能力可运行大模型,通过简单配置和API调用即可快速生成并部署代码至板载单片机,实现精确控制。文中项目也颇具代表性,您是否了解Lattepanda sigma?您对使用该板有哪些经验或者疑问?欢迎留言,和DigiKey的朋友们一起分享交流!

******

如有任何问题,欢迎联系得捷电子DigiKey客服团队。

中国(人民币)客服

- 400-920-1199

- service.sh@digikey.com

- QQ在线实时咨询 |QQ号:4009201199

中国(美金)/ 香港客服

- 400-882-4440

- 8523104-0500

- china.support@digikey.com

到微信搜寻“digikey”或“得捷电子”

关注我们官方微信

并登记成会员,

每周接收工程师秘技,

赚积分、换礼品、享福利